L’espressione “Deepfake” è un termine in uso dall’anno 2017, per descrivere la tecnica dell’intelligenza artificiale, che produce immagini o video dall’aspetto ingannevolmente reale.

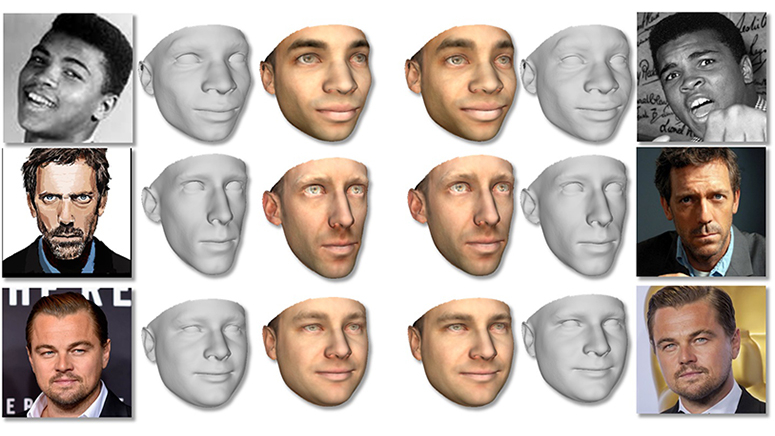

La tecnica si basa su delle reti neuronali artificiali, che generano in modo autonomo dei media (immagini/video) falsi. “Deepfake” è una combinazione dei termini inglesi “Deep Learning” (Classe di metodi di ottimizzazione per le reti artificiali) e “Fake” (imitazione). In tutto si tratta di un complesso di manipolazione di video ed immagini che con l’aiuto di reti neuronali artificiali sono in grado di falsificare immagini digitali con una precisione del 97%.

UNA TECNOLOGIA USATA NEL CINEMA

Questa tecnologia è stata ampiamente utilizzata nell’industria cinematografica, per fare risuscitare attori morti come “Leila” (Carrie Fisher) nell’ultimo episodio del film “Star Wars”. Ma ora il tutto va oltre.

Le espressioni facciali di una persona, vengono utilizzate in modo abusivo, infatti i volti o i corpi al completo di donne o di donne famose vengono falsificati ed inseriti abusivamente su siti per utilizzo pornografico. La scienziata “Danielle Citron” dell’Università di Boston ritiene che “la tecnologia venga utilizzata come arma contro le donne”.

Da quando Facebook un anno fa ha introdotto “DeepFace” il giornale online “Huffington Post” ha descritto la tecnologia come “inquietante”, anche dal punto di vista della discussione controversia della protezione dei dati.

UNA PRECISIONE SPAVENTOSA

Infatti “La American Electronic Frontier Foundation” e altre organizzazioni per la protezione dei dati, hanno lavorato per sviluppare un “codice dei volti”, ma dopo 16 mesi le trattative sono state interrotte. Peccato, perché alle persone bisogna chiedere se desiderano essere postate al riconoscimento facciale automatico.

Il software è ancora in fase di sviluppo, ma già adesso contiene una precisione spaventosa. Se invece analizziamo la tecnologia dal punto di vista della protezione dei dati, il tutto è orrido è manipolativo, bisogna dunque chiedersi se questo non porrà fine all’anonimato.

E non solo questo, se si pensa alle 4.000 immagini utilizzate per testare il software e anche interessante chiedersi cosa potrebbero dire le 4.000 persone le cui immagini da utente sono state usate per testare il software.

I POTENZIALI DANNI

Per quanto il software possa essere un potenziale danno, “Sam Gregory” direttore del programma dell’organizzazione per i diritti umani “Witness” sottolinea che “bisogna concentrarsi sulla soluzione, invece di restare paralizzati dalla paura e che l’educazione digitale è fondamentale, ma che finora non è stata trattata a sufficienza. Come si fa in modo che le persone si facciano dunque delle domande quando si imbattono in un’immagine impeccabile?”

Terminiamo scrivendo che è molto importante educare le persone che lavorano con dei gruppi vulnerabili e che potrebbero mettere in cattiva luce persone e i diritti umani.